「SAO (ソードアート・オンライン)」は、Virtual Reality方式のMMORPG (Massively Multiplayer Online Role-Playing Game: 大規模多人数同時参加型オンラインRPG) が舞台となるお話で、ベースとなった小説自体は2002年に発表、さらに2012年にはアニメ化されて大きな話題となりました。

その作中に登場するMMORPGの「ソードアート・オンライン」が公開されるのは2022年なのですが、

「実は2016年に、開発者である茅場晶彦氏と日本IBMが共同でSoftLayer上にプロトタイプを開発し、一部のユーザーだけを対象にアルファテストが実施されていた」

という設定で、実際に2016年3月にアルファテストが行われたのです。このアルファテストには、定員約200名に対し、応募総数は10万名以上(競争率は約500倍)と驚異的な注目を集めました。

ということでCHANGE-MAKERSも、このアルファテストへ参加できたので、2月の”篠崎愛さんのお部屋”に続きVR体験のレポートをお届けします。

まずは全身をスキャン

アルファテストに参加する上で、しっかりと予習 (アニメを視聴)し、当日会場に臨みます。なにぶん、高すぎる注目度ゆえ、開催場所は極秘扱いです。現場のスタッフも白衣をまとい、実験っぽさを醸し出しています。

簡単な説明の後、まずは全身を3Dスキャンします (作中でも、SAOへアクセスする前に同じようにスキャンした、という設定がありました)。スキャンは、白いシーツで周囲から仕切られた、広いエリア内(なぜか写真撮影禁止)で実施されましたが、エリア内には巷でもよく見かける「Kinect」が正面に2台、後方に2台、頭上に1台セットされており、立ったまま両手を水平に伸ばした大の字の体勢で撮影されました。

(左の白い仕切りの中がスキャン エリア)

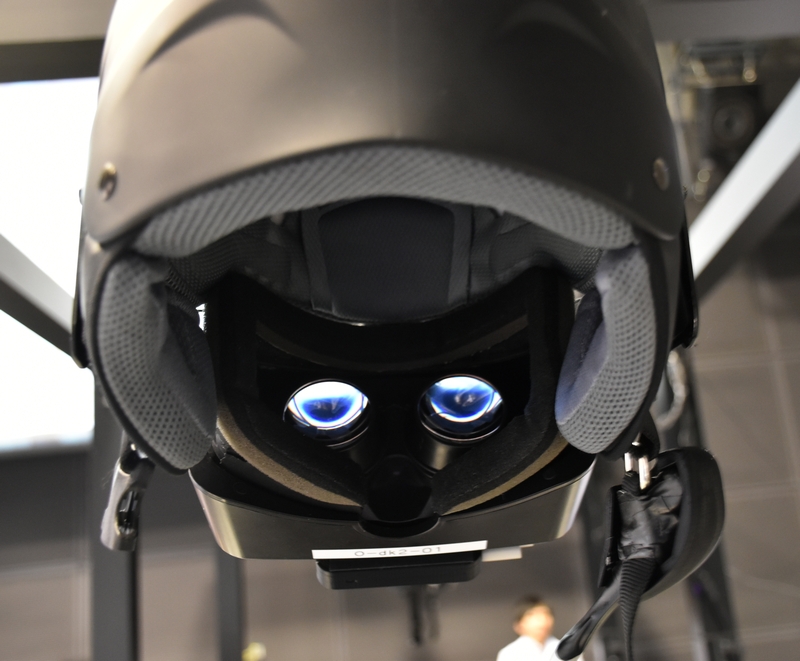

Oculus Rift+様々なガジェットで再現されたあの「ナーヴギア」

アルファテストは4人1組で行われます。キャプチャ後、ほとんど待つこともなく4人それぞれが、ゲージで囲まれたブースに案内されました。そして、やはり一番気になるのがヘッドマウントディスプレイとなる「ナーヴギア」。

被ってみてまず驚いたのが、周囲の状況がスクリーン越しに見えていることでした。一瞬、それがバーチャルな映像なのか、それともリアルなのかがわかりませんでしたが、自分の手を”見る”ことで、リアルな映像だということがわかりました。

このナーヴギアの詳細は未確認ですが、

・Oculus Rift DV2

・フロント3Dカメラ

・Leap Motion

・Bluetooth マイク

などで構成されているようです。目の前のリアルな映像はフロントカメラで撮影し、さらに手の動きはLeap Motionでキャプチャしていると思われます。一方、ゲーム内の移動に必要となる足の動きのキャプチャは、専用シューズにベルクロテープで装着されたセンサーが利用されているようです。

VRゲームの場合、フィジカルな動きをどう測定するかが、気になるところですが、ナーヴギアはSAOの世界観と同じく、物理的なコントローラを一切排除しています。

「リンク スタート!」で、忠実に再現されたSAOの世界にダイブ。

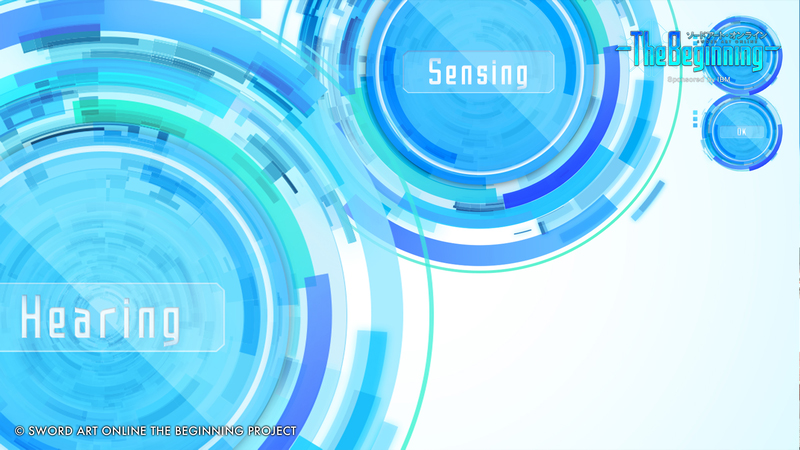

全メンバーの準備が整った後、SAOと同じく「リンク スタート!」のかけ声で、いよいよゲームスタート。瞬間、アニメで見たあの、吸い込まれていくようなシーンとサウンドが、忠実かつ圧倒的な迫力で再現されていきます。

センサーや言語などのセットアップ、ログイン、キャラクター登録画面などを次々に通過し、バーチャルな世界へ降り立ちました。ここまでは、ほぼアニメのままと言っても過言ではありません。

周りを見ると、他のプレイヤー達が見えますが、その姿はさきほどスキャンしたデータが基になっています。

モーションキャプチャによるUIで、操作感もSAOを再現。

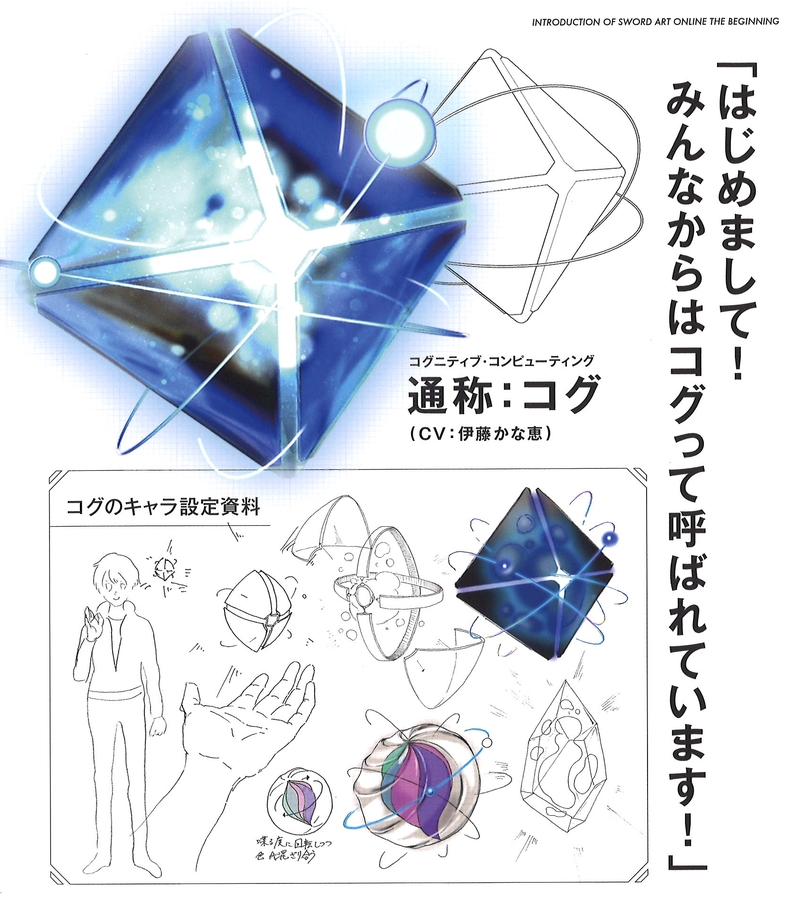

最初に登場するキャラクターが、”コグニティブコンピューティングシステムを基に開発された”という「コグ」。ゲーム内での心強い案内役ということですが、どこかで聞いた声です。資料によると、なんと声優は”伊藤かな恵”さんでした。ファンであればピンとくる声優さんですね。何かの伏線でしょうか・・・。

(参加者に配布されたSPECIAL BOOKLETより)

(参加者に配布されたSPECIAL BOOKLETより)

操作方法などがレクチャーされた後、いよいよ最初のステージとなる「はじまりの街」へ入りました。

武器の実装など、メニューの操作もアニメ通りです。Leap Motionでキャプチャされた自分の手の動きにあわせて、ディスプレイの中の手も同じように動きます。その追従性もなかなか高く、ちょっとした動きも捕らえるようです。(さすがに手を重ねた場合は、隠れた方の手をキャプチャできませんでした)

移動は、その場で足踏みをすると前進し、体の向きを変えると進行方向も変わります。足の甲のセンサーを検知しているため、少々大げさ気味に足を持ち上げる必要があります。

(はじまりの街の映像)

(はじまりの街の映像)

(右手には剣を持っているのです)

(右手には剣を持っているのです)

(キャプチャされた自分のアバター。体の側面はデータがとれていないもよう)

(キャプチャされた自分のアバター。体の側面はデータがとれていないもよう)

ひとしきり、バーチャル感を味わった後、いよいよ戦闘シーンへと移行。巨大なボスキャラをチーム全員で倒すというシナリオになっています。

こういう大きなものをVRで見ると、その迫力たるや強烈なものがあります。ちょっとした怖さを感じるといっても過言ではありません・・・。

(他の人に比べると、動きが地味すぎると指摘あり・・・)

そうこうしているうちに、必殺技などを駆使しながらボスキャラを倒し、めでたくアルファテストの終了となりました。

2016年現在のOculus Riftの解像度と戦闘シーンの操作性

戦闘シーンの操作は単純化されており、両手(二刀流)で攻撃するか、防御するか、なのですが、ここの操作感については、まだまだ実際の感覚とのギャップがあるように感じました。動きは概ね追従されていたように感じるのですが、攻撃が効いているのかどうか、また、防御も上手くいっているのかいないのか、がわかりづらく、何となく時間が過ぎて戦闘が終わったという気もします。

そして、何よりも気になるのが、Oculusの解像度でした。(恐らく)DV2ということで解像度が低く、画面の粗さは否めません。これは、この記事の冒頭で触れた“篠崎愛の部屋でバレンタインのチョコをもらってドキドキした話”と同様、ピクセルが視認できてしまいます。ただ、2016年初で市場で入手できるもので組み合わせており、この先のデバイスの進化に伴ってクリアされていくことでしょう。

何年か後に展開されると期待したいベータテスト、正式版では、きっとさらにスゴイことになっているに違いありません。

IBMのテクノロジーがSAOを下支え

ゲームの中に入っている時には、その裏でどういうテクノロジーが動いているのかわかりませんし、むしろ、わからない方が、きっと良いのだと思います。今回の場合も、IBMのSoftLayerがどう支えているのかは、恐らく全Playerともに実感はできていないでしょう。

しかしながら、文字通り「MMO」―VR空間で多人数で同時にプレイするためには、強力なGPUパワーや連携するサーバー間に高品質なネットワークは欠かせませんし、時と共に利用者数が刻一刻と変化しても、安定してそのパワーが利用できるということも必須といえるでしょう。

そういった要望にしっかりと対応できるのが、IBMのSoftLayerという事のようで、その特徴を大きくまとめると、

- ベアメタル・サーバー(物理サーバー)をカスタマイズすることができて、自社専用の環境とすることができること。仮想サーバーとも組み合わせることができ、システムに合わせたクラウド・サーバーを選択できること

- グローバルのデータセンターを結ぶ10Gbpsネットワーク上のプライベートネットワーク通信が無料で利用できること。さらに、アウトバウンドの通信も無料枠の設定が大きく、通信料込みでクラウドに関する費用予測の正確性が高いこと

- Watsonを始めとしたAI機能やアナリティクス、ブロックチェーンやサーバーレスなど新しい技術をアプリに試しに使ってみることが簡単にできるPaaS基盤 Bluemix が含まれていること

が挙げられると思います。