現在の人工知能に関する潮流は、ビッグデータとディープラーニング(深層学習)によってもたらされた「3度目のブーム」と言われています。ディープラーニングというと、「AlphaGo」を開発したGoogleが一歩進んでいるイメージがありますが、ここではIBMのディープラーニング戦略について触れてみたいと思います。

従来型機械学習の集大成とは

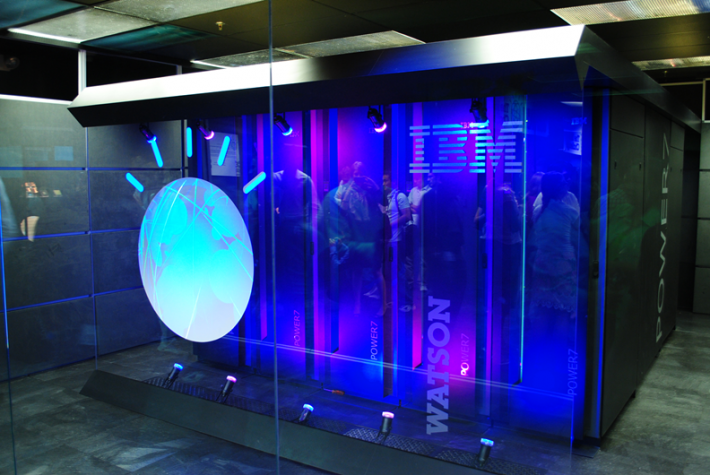

IBMの人工知能といえば、なんといってもWatsonです。CMも多数放映しており、その存在感は今やかなりのもの。ただ、このWatsonはもともとディープラーニングとは異なる、従来型の機械学習を利用したシステムでした。Watsonは自然言語を解釈し、自身が蓄積している情報を元にした仮説の生成や評価を行います。

Watsonの知名度を飛躍的に高めたのは米国の人気クイズ番組。本や百科事典など2億ページ分のテキストデータ(70GB程度、約100万冊の書籍に相当)の知識を携え、人間のクイズチャンピオンに勝利しました。

これこそIBMが提唱している「コグニティブ(認知)コンピューティング」であり、実はWatsonは従来型機械学習の集大成だったのです。

参考:人工知能を「未来の技術」から「今すぐ使える技術」に引き寄せたワトソン

ディープラーニング技術のAlchemyAPIを買収

Watsonは最新の技術を取り込んで、日々進化しています。もちろんディープラーニングもそのひとつ。IBMは2015年3月、コロラド州デンバーに拠点を置くAlchemyAPIを買収しました。AlchemyAPIはディープラーニングを活用し、企業向けのリアルタイムデータ分析や非構造化データ処理を目的とした高性能アプリケーションを開発する企業。この買収の目的は、Watsonのコグニティブ(認知)コンピューティングをディープラーニング技術で強化させるためと考えられます。

参考:AlchemyAPI社の人工知能がBluemixで利用できます。

従来型機械学習の集大成であるWatsonは、「無数の選択肢の中から統計的に確かなものを絞込んでいく」方法を採ります。一方、ディープラーニングは「人間の脳の考え方に近い」方法で選択していきます。IBMはAlchemyAPIの深層学習型技術をWatsonのコア・プラットフォームに統合して、大規模なデータ・セット内の階層をすばやく識別できると考えたのです。

このテクノロジーによりWatsonは、業界固有のさまざまなデータを幅広く取り込み学習する能力や、絶えず進化するオントロジー(概念定義や体系化)に対処できる能力等が向上しました。なおIBMは、AlchemyAPIから獲得したディープラーニング技術をAPIで公開しています。

IBM Watson Developer Cloud, BETA Visual Recognition(リンク先英文)

ディープラーニング向けのLinuxサーバを発表

IBMのディープラーニング戦略は、Watsonに代表されるようなソフトウェアだけではありません。ハードウェアの分野でも、ディープラーニングに対応した製品の開発に力をいれています。例えば米IBMはこの9月、新たなLinuxサーバ3種類を発表しました。いずれも新しいチップと技術が組み込まれたもので、x86サーバと比較してより高いレベルのパフォーマンスと計算効率を実現。1ドルあたりのパフォーマンスが80%向上するとしています。

これらには人工知能、ディープラーニング、ハイパフォーマンス・データ・アナリティクスをはじめ、膨大な計算処理を必要とするワークロードを高速化するためのユニークな設計が実装されおり、「このシステムを活用することで、企業やクラウド・サービス・プロバイダーはデータセンターのコスト削減を実現できる」とIBMは述べています。

発表された3種類のサーバは以下の通り。

①「IBM Power System S822LC for High Performance Computing」。新プロセッサ「IBM POWER8 with NVIDIA NVLink」を搭載しており、x86ベース・システムの5倍のデータ処理の速度を実現します。②「IBM Power System S822LC for big data」、③「IBM Power System S821LC」は、どちらもビッグデータ向けに位置付けられたLCサーバ。

これらの高スペックサーバを使えば、企業やクラウド・サービス・プロバイダーは、データセンターでのサーバー乱立を抑えることができ、コストを削減できるとIBMは強調しています。今後はGoogleだけでなく、同社のディープラーニング戦略にも要注目です。